色域顾名思义是色彩的范围。在很大程度上,色域与色彩空间是同义词,但是矫情的话,也可以说有区别——色域指显示设备能够表现的颜色,在特定色彩空间内的范围。

显示器达不到人眼的色彩分辨极限,是因为那样做1.色彩管理复杂2.制造成本太高。

色彩是人眼对光线波长和振幅的反映,一般人可以感知可见光范围是400-760nm波长,有些人更多一些,为了清晰准确地管理色彩,我们动用数字语言定义每种色彩。

色域/色彩空间/色域空间(color space)是通过空间坐标方式来量化分析色彩。色彩包括色相(hue)、饱和度(saturation,又称彩度、纯度)和明度(lightness)三个属性。为定位这三个属性,最直接的色彩空间是三维的,但二维似乎更为常见、还有一维、四维的。

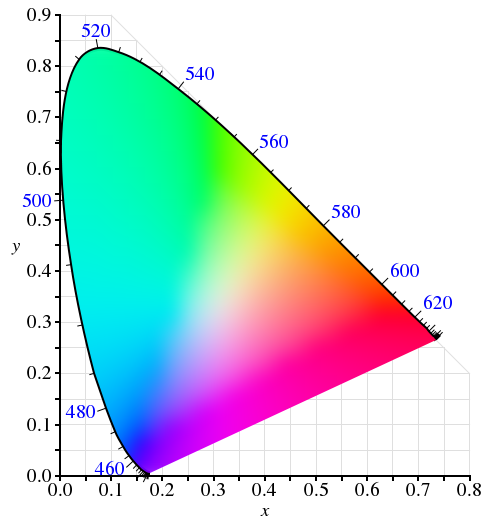

为简化问题,我们暂不讨论明度,以CIExy色度(chromaticity,指色相和饱和度的组合)图谱的二维坐标系对应的RGB色彩模型来讨论。

在CIE(根据国际照明委员会)色度图谱是个二维坐标系,x、y轴是RGB三色分量的函数,人类肉眼能够分辨的色度范围是一个马蹄形,马蹄形外围黑色实线上的数值对应色光的波长。从视觉角度来说,这个马蹄形就是最大的色彩空间,包含所有的色度。

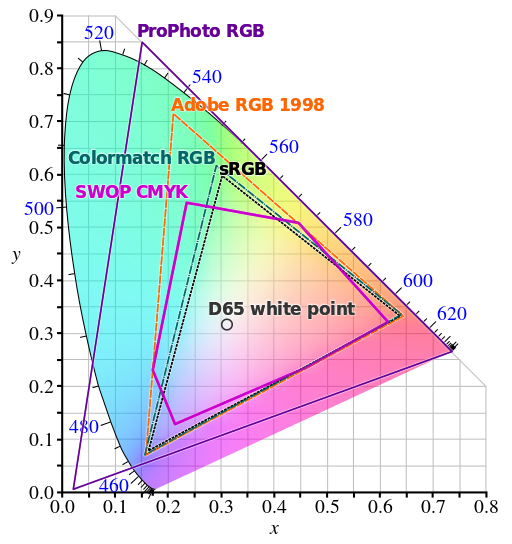

RGB彩色管理是根据人类视锥细胞识别颜色的生理特点,通过红绿蓝(RGB)三色的混合叠加混合产生各种不同的颜色。RGB三个分量,能够在色度图上占据的必然是一个三角形,三个顶点分别是“正”红、“正”蓝、“正”绿。这个三角形占据的坐标空间就是某一特定的“RGB色彩空间”,或者叫“RGB色域”。目前我们不同标准定义了多个RGB色彩空间,大小各有不同。最常见的是sRGB,其次是更大的Adobe RGB。但绝大多数RGB三角形空间都小于这个马蹄形范围的。

因为要完全涵盖马蹄形,这个三角形必须非常之大,其中有大量空间对应人眼看不到的颜色,这会浪费大量的资源。同样的数据量,如果很多数据资源无用,剩余数据资源定义色彩的精度就会下降。这是大家不愿见到的。更何况sRGB这样较小的色彩空间也可以比较有效的描绘视觉效果。

还有一个严重问题,如果不惧数据庞大,让色彩空间大于人类可识别的400-760nm波长范围,从色彩管理上来说也没什么,但显示时就需要红外和紫外通道。这两个通道人类肉眼无法识别,还是需要红、绿、蓝通道来还原的色彩空间,又回到了马蹄形内的三角。

所以,色彩管理时,大多数色彩空间都不会达到人眼的色度范围的极限。

再说人眼分辨色彩细微差异的极限。这个在色彩管理上倒不是什么大问题了。

早年间常常提到16色、256色(8bit色彩)、16bit和24bit真色彩的区别,今天数码相机则有8bit、14bit色彩深度只说。以24bit真色彩为例,24bit指RGB三种颜色每一个的分量都有8bit数据,也就是数码相机所谓的8bit色彩深度。8bit数据可以记录256级不同的亮暗程度(色阶),每一个像素通过3个8bit单色的混合,可以呈现出16,777,216种不同的颜色,也就是所谓的16M色。以此类推,14bit色彩深度就是42bit色彩,RGB每个分量16,384级不同亮度,总共4,398,046,511,104种颜色。

人眼不要说分辨4,398,046,511,104种颜色了,6,777,216种也分辨不出来啊。换句话说,如果单色色阶只变化1/256,真的分辨不出。所以色彩管理上来说,24bit色彩(8bit深度)已经超过了人眼分辨色彩细微差异的极限。

再来说说显示器的色域(color gamut)。这个色域,很多时候指显示设备在某一给定色彩空间内,所能显示色彩的范围。

当然,无论色域范围还是色彩细微差异查过人眼极限的显示器都是可以存在的。色彩细微差异可能很重要,很多显示器都能做到。至于色彩范围达到人眼极限,理论上可行,但是需要增加更多的通道,效果还不一定显著,投入巨大有必要吗?

投稿邮箱:chuanbeiol@163.com 详情请访问川北在线:http://www.guangyuanol.cn/